얼굴 감지 기술은 인종차별적일까?

어느 트잉여의 이야기

저는 트위터의 오랜 유저입니다. 2011년 4월에 시작했으니 올해로 딱 10년째를 맞겠군요. 이미지를 올릴 수 없던 시절을 겪어보지는 않았지만 yfrog 등 외부 이미지 서버를 사용해서 이미지를 올리던 시기부터 시작해 바로 업로드되는 사진, 동영상, GIF, 라이브 방송과 음성 메시지, 프로필에 뜨는 휘발성 사진까지. 아주 정돈된 전문성은 아니지만 지난 10년 트위터를 주 SNS로 활용하며 트위터의 변화를 함께 경험해왔습니다.

사진이나 동영상 등이 어떻게 처리되느냐에 따라서 트윗을 올리거나 읽는 사람의 경험도 달라지기에, 이런 변화마다 메타개그가 유행하기도 합니다. 최근에는 트위터 사용자가 가로나 세로로 긴 이미지를 업로드할 때 자동으로 미리보기로 삼을 부분을 선택해 타임라인에 보여주는 기능이 추가되었습니다. 중요하다고 판단되는 부분 - 얼굴이나 텍스트 등이 미리보기에 보이도록 하고, 트윗을 클릭하면 전체 사진이 보이는 식이지요. 그래서 ‘사진을 누르면 예상치 못한 게 보여요’ 하는 식의 메타개그가 밈이 되었습니다.

{: width="400" } {: width="400" } |

|

|---|---|

| 타임라인에 보이는 사진 | 클릭하면 보이는 사진 |

귀여운 고양이를 봤으니 이번에는 다른 경우도 볼까요. 작년 가을 트위터를 아주 뜨겁게 달군, 유명한 트윗입니다.

{: width="400" } {: width="400" } |

|

|---|---|

| 타임라인에 보이는 사진 | 클릭하면 보이는 사진 |

미리보기 생성 알고리즘과 이미지 위치의 상호작용을 파악하기 위해, 이 사진은 두 인물사진의 위치를 변인통제했습니다. 그럼에도 불구하고 두 경우 모두에서 선택된 쪽은 백인인 미치 맥코넬이었습니다. 트윗 텍스트를 제대로 읽지 않았다면 사진에 버락 오바마가 있었으리라 짐작할 수도 없을 정도로 말이에요.

저는 이 텍스트를 제대로 읽지 않고 대강 사진을 클릭하고 스와이프해서 두 사진 원본을 확인했는데, 그래서 더 충격을 받았습니다. 저는 이 사건 전에는 미치 맥코넬이 누군지도 몰랐거든요. 미국 공화당 당 대표라고 하네요.

이 ‘실험’이 몰고 온 반응은 그야말로 뜨거웠습니다. 수천 번 리트윗되고 수만 개의 마음(좋아요)를 받았습니다. 사람들은 너나 할 것 없이 조건을 조정해서 비슷한 실험을 했습니다. 어떻게 조건을 바꿔줘야 오바마를 미리보기에서 볼 수 있는지 테스트하고, 다른 백인과 흑인 인물 사진은 어떤지, 배경이나 포인트 아이템 색깔, 인물의 성별을 달리하면 어떤지 말이지요.

{: {: |

|---|

| 이미지 출처(좌상단, 우상단, 우하단) |

개별적이고 산발적으로 진행된 실험들이라 결과를 한데 모아보지는 못했기에 막연한 인상 또는 관찰 결과에 가깝습니다만, 흑인과 백인의 조합에서는 흑인의 얼굴이 생략되는 경우가 많았습니다.

열흘 후 트위터 공식 블로그에는 이 사태(?)에 대한 해명이 올라왔습니다. 새로운 알고리즘을 도입하기 전에 여러 인구 그룹에 대해 테스트를 했으나 뚜렷한 편향은 발견하지 못했다고, 하지만 이 기술의 위험성에 대해서는 인지하고 있으니 추후에 고쳐나가겠다고 트위터 측은 설명했습니다. 소동은 그렇게 마무리되었지만, 이 글을 올리는 지금까지도 위 트윗 미리보기에서는 버락 오바마의 얼굴이 보이지 않습니다.

이런 일은 이번이 처음이 아닙니다. 얼굴인식 기술 정확도가 흑인 집단에서 떨어진다는 지적은 꾸준히 제기되었지요. MIT 미디어랩에서 개발한 얼굴 인식 프로그램이 개발자인 흑인 여성의 얼굴을 감지하지 못한 사건도 있었고요. 이들이 이 인공지능 기술 편향과 싸우는 여정을 담은 다큐멘터리 영화까지 있습니다.

인공지능이 지금처럼 트렌디해지기 전에는 사진 보정 앱에서 누군가의 눈이 잡티 취급되어 지워졌다는 우스갯소리도 있었지요. 저 역시 친구와 사진을 찍으며 비슷한 일을 겪었습니다. 조금 어두운 실내에서 같이 사진을 남기고 싶어 핸드폰을 들었는데, 흑인인 친구의 얼굴은 어두운 배경 취급되어 거의 보이지 않았습니다. 제 얼굴만 밝게 처리되어 옅은 녹색 직사각형이 둘렸지요. 민망해하는 제게 친구는 항상 있는 일이라며 웃어넘겼습니다. 카메라의 얼굴 인식 기술이 누군가의 얼굴을 없는 취급하는 게 항상 있는 일이라니, 어처구니없고 화가 나더라고요.

자연스레 이런 질문이 떠오릅니다. 과연 얼굴인식 기술은 인종차별적일까요?

사실 저는 이 질문을 피하는 편입니다. 제가 답하기 너무 어렵고 복잡한 질문이기 때문입니다. 일단 인종차별이나 인종차별적인 행위를 정의하는 방법이 너무 다양하고, 기술의 가치중립성 역시 정리하고 넘어가야 합니다. 자연인도 법인도 아닌 기술이 어떻게 인종차별이라는 비윤리적 행위를 할 수 있는지도요.

대신 저는 그나마 제가 공부해온 방식을 이용해서 질문을 바꿉니다. 내 역량에 맞춰서 문제를 최대한 단순화시키고, 어떤 개선책으로 상황을 바꿀 수 있는지를 고민하는 식으로요. 제가 역으로 제시하는 질문은 이것입니다.

- 구체적으로 얼굴 인식 기술의 어느 부분이 특정 집단의 얼굴을 잘 인식하지 못하는 문제와 관련이 있을까? 단순한 우연일까, 아니면 설계상의 결함일까?

얼굴 인식 기술의 이해

우선 얼굴 인식 기술과 얼굴 감지 기술을 구분하고 넘어가도록 하겠습니다. 얼굴 감지(face detection) 기술은 ‘주어진 이미지 안에 얼굴이 있는지’에 답합니다. 디지털카메라가 사람의 얼굴을 찾아주고 얼굴 주변에 직사각형 프레임을 씌워 주는 것이 대표적인 예시이지요. 한편 얼굴 인식(face recognition) 기술은 ‘주어진 이미지 안의 얼굴이 누구의 얼굴인지’에 답하는 기술로, 애플의 페이스아이디(FaceID)나 페이스북의 사진 인물 자동 태그가 그 예시가 될 수 있습니다.

두 기술 모두 중요한 기술이고, 최근 들어 주목받은 쪽은 얼굴 인식 쪽이긴 합니다만, 이 글에서는 트위터 사례와 직접적으로 이어지는 얼굴 감지 기술에 집중하겠습니다. 특히 이 기술이 ’얼굴다운 특징(facial feature)’을 어떻게 정의하는지, 거기에 깔린 얼굴에 대한 전제는 무엇인지에 대해서요. 여러 얼굴다운 특징이 어떤 과정을 거쳐서 선별되고 종합되어 최종 판정을 내는지는 이 글에서 다루지 않겠습니다.

비올라 존스 알고리즘

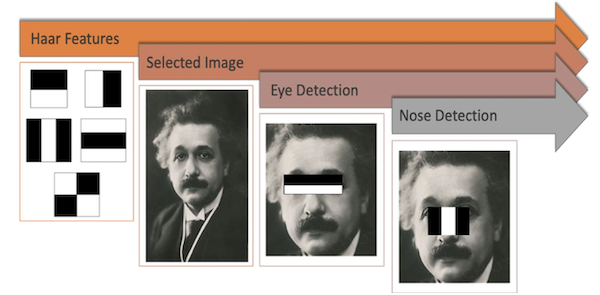

첫 번째로 소개할 기술은 바로 비올라 존스 알고리즘(Viola Jones algorithm)입니다. 여기에서 정의하는 얼굴다운 특징을 몇 가지 보여드리면 이렇습니다.

|

|---|

| 비올라 존스 알고리즘의 작동 원리. 출처 |

인접한 직사각형 영역의 명도 차가 적당히 크다면 (검은색 직사각형 아래의 영역이 흰색 직사각형 아래 영역보다 적당히 어둡다면 ) 이 ‘얼굴다운 특징’이 있다는 것이지요. 이런 특징들을 이용해 이목구비나 얼굴 가장자리 부분 등을 찾아내고 결과를 잘 종합해서 얼굴 영역을 찾아냅니다. 총 6000여 개의 ‘얼굴다운 특징’ 중에서도 가장 중요하게 취급되는 것들이 바로 위에서 보이는 직사각형 쌍입니다. ‘눈가와 코, 얼굴 가장자리 등에 그림자가 드리우면 얼굴이다’라고 할 수 있겠군요.

CNN

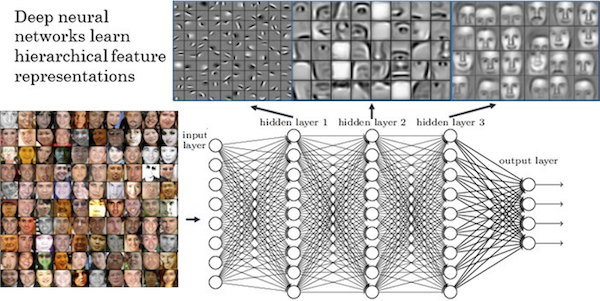

두 번째로 소개할 기술은 바로 뉴럴 네트워크(인공 신경망) 기반의 이미지 인식 기술인 Convolutional Neural Network(이하 CNN)입니다. 비올라 존스 알고리즘이 ‘얼굴다운 특징’을 그림자로 생긴 명도 차로 단순화해서 찾아냈다면, CNN의 작동방식은 좀 더 복잡합니다. CNN에서 사용하는 ‘얼굴다운 특징’ 예시는 이렇습니다.

{: {: |

|---|

| CNN의 작동 원리. 출처 |

인간 얼굴의 핵심 요소를 표현하는 이미지 조각들을 미리 정해 두고 주어진 이미지와 비교해 ‘얼굴다운 이미지 조각’이 있는지 가려내는 것이지요. 비올라 존스 알고리즘에서 눈두덩이 그림자를 찾았다면, CNN에서는 눈 모양을 직접 찾아냅니다. 이 이미지 조각들에는 이목구비뿐 아니라 기본적인 선/면 요소, 전체적인 얼굴 모양 등이 포함되고, 인공 신경망의 여러 은닉층(hidden layer)에서 다양한 방식으로 조합되어 최종적으로 얼굴인지 아닌지, 또는 누구의 얼굴인지 판단을 내릴 수 있습니다.

{: {: |

|---|

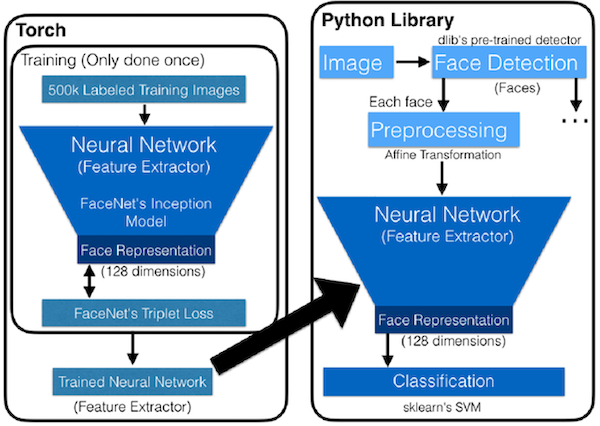

| CNN의 필터 트레이닝 파이프라인. 출처 |

그렇다면 여기에서 쓰이는 ‘얼굴다운’ 이미지 조각들은 어떻게 만들어질까 ? 바로 우리가 빅데이터라고 부르는 수많은 얼굴 사진 이미지를 통해 ‘얼굴’을 학습한 인공 신경망 모델을 통해 만듭니다. 눈, 코, 입, 귀의 위치나 얼굴 영역이 이미 표시된 이미지들을 인공지능 모델에 집어넣어 일반적인 눈, 코, 입, 귀, 또는 전반적인 얼굴 형태라고 할 수 있는 이미지를 생성하는 것이지요. 말하자면 ‘인공신경망 모델이 미리 학습해둔 사람 얼굴과 비슷하면 얼굴이다’가 되겠습니다.

이 기술들은 인종차별적인 목적을 수행하기 위해 만들어지지는 않았습니다. 직접적이고 노골적으로 특정 집단을 배제하는 선언 역시 하지 않습니다. 각 기술의 논리에도 일리가 있습니다. 우리가 사람의 얼굴을 생각할 때 떠올리기 쉬운 특징을 각자의 방식으로 단순화한 것이니까요.

하지만 그 단순화하는 작업이 인간 얼굴에 대한 좁은 전제 위에 만들어졌다면 어떨까요?

화제를 아주 잠시 돌려, 제 경험을 나눠볼까요. 지금 학교에서 같은 수업을 듣는 학생들과 밖에 나와 스몰토크를 하던 때였습니다. 8월의 오후 1시라 볕이 꽤 강했어요. 선글라스를 끼고 있긴 했지만 역부족이었고 저는 눈을 제대로 뜨지 못하고 쩔쩔매고 있었습니다. 그런데 같이 이야기를 하는 학생들을 둘러보니 아무도 그렇게까지 힘들어하지 않더라고요. 심지어 정면으로 해를 바라보고 있었는데도요. 눈가에 진 진한 그늘이 눈을 강한 빛으로부터 보호해준 덕이었습니다. 저는 수업의 유일한 동아시아인이었고, 같이 이야기하던 나머지 학생들은 모두 서유럽 출신의 백인이었습니다.

비올라 존스 알고리즘에 깔린 ‘인간 얼굴에는 공통적인 골격, 돌출부와 함몰부가 있으니 그런 부분들에 생기는 그림자를 통해 얼굴을 찾아낼 수 있다’는 전제는 백인에게 최적화되었습니다. 눈가와 코의 굴곡이 그렇게까지 선명하지 않은 동아시아계, 또는 얼굴에 진 그림자와 본래 피부색의 밝기 차가 크지 않은 아프리카계의 얼굴은 이 전제에서 빗겨있습니다.

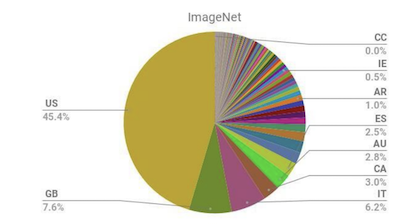

그렇다면 CNN은 어떨까요? 얼굴에 대한 구체적인 정의가 아닌 많은 양의 학습 데이터에 기대기 때문에 이런 문제로부터 자유로울 것 같지만, 실제로는 그렇지 않습니다. 인공신경망 모델을 학습시키는 데 쓰이는 데이터의 절대다수가 영미 및 유럽권에서 오기 때문입니다. 이런 학습 데이터를 통해 얻어낸 ‘얼굴다운 이미지 조각’은 백인에게 최적화될 수밖에 없습니다. 전형적인 백인의 얼굴과 멀수록 얼굴답지 않다고 판정을 내릴 가능성은 커집니다.

|

|---|

| Imagenet 데이터셋의 지역 정보.[1] |

그리고 두 기술 모두에 깔린 전제가 있습니다. 바로 얼굴은 밝고, 그림자든 뭐든 ‘어두운’ 경계를 통해 이목구비를 찾아낼 수 있다는 것입니다. 비올라 존스 알고리즘에서는 얼굴과 그림자를 구분하고, 예시 그림에서 볼 수 있는 CNN의 이미지조각 역시 검은 배경에 밝은 얼굴을 기본으로 하고, 상대적으로 어두운 모발이나 윤곽선을 통해 얼굴을 구분하지요.

얼굴은 '밝은 것'?

얼굴 감지 기술이 피부색이 어두운 집단에서 전혀 작동하지 않는 것은 아닙니다. 하지만 이는 얼굴 감지 기술이 어두운 피부톤에서도 잘 동작하기 때문보다는 애초 빛을 가해서 사진을 찍었기 때문에 가깝습니다. 피부에 반사되는 빛으로 ‘밝은’ 피부톤을 만들어내거나 아예 강하게 보정하는 식으로요. 사진이 귀하고 비싸던 시절에는 조명 환경이 잘 갖춰진 스튜디오에서, 사진이 흔하고 값싼 시절에는 자동 보정이나 후보정을 통해서 피부톤이 어두운 얼굴들은 ‘밝게’ 기록되었습니다.

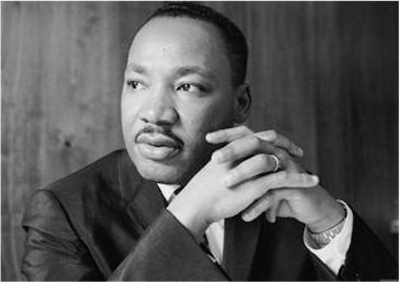

|

|---|

| 마틴 루터 킹의 생전 사진. 출처 |

그렇다면 누군가의 어두운 피부색을 최소한의 빛 보정으로 담은 사진은 대체 어디에 있을까요? 제가 실제로 본 이들의 피부색이 그대로 담긴 사진이 어딘가에는 있을 텐데요. 이 글을 쓰기 전에 저는 구글 이미지에 흑인 유명인사의 이름을 검색해보기도 하고, 흑인 미국인 친구의 인스타그램에서 셀카를 둘러보기도 하고, 작년 미국의 흑인 인권 시위 보도 사진을 검색해보기도 했지만 다들 제가 실제로 봐온 피부톤과 미묘하게 달랐습니다. 요즘은 사진을 많이 찍고 잘 나오는 걸 고르니까, 얼굴이 어둡게 나온 사진은 다 거르는 게 아닌가 싶더라고요. 제가 이름을 알고 있는 역사 속 흑인 위인들의 이름을 검색해봤지만 마찬가지였습니다. 저에게까지 이름이 기억될 만큼 중요한 사람들이라 그런지, 적절한 플래시와 반사판과 함께 찍힌 사진만 보이더라고요

끝내 누군가의 어두운 피부톤을 그려낸 사진을 찾아내긴 했습니다.

|

|---|

| 목화밭에서 일하는 흑인 노예 가족(1860년대 사진) 출처 |

1860년대 조지아의 목화 농장에서 일하는 흑인 노예 가족의 사진에서요.

물론 제가 공부해온 영역 밖이라 제 검색력이나 배경지식이 부족했던 것일 수도 있습니다. 그래도 저는 의문이 듭니다. 사진의 역사에서 어떤 ‘사람’의 어두운 피부빛을 담으려는 노력은 얼마나 이루어졌을까요? 그런 매체 위에 만들어진 이미지 처리 기술, 특히 얼굴 인식 기 술은 피부톤이 어두운 사람의 얼굴을 얼마나 잘 잡아낼 수 있을까요?

사진에 대해 제가 할 수 있는 말은 별로 없으니 다시 기술의 언어로 돌아가 보겠습니다.

왜 중요한가?

여태까지 우리는 얼굴 인식 및 감지 기술이 왜 특정 집단에게는 잘 작동하지 않을 수밖에 없는지 이야기했습니다. 이것은 이론의 여지 없는 기술의 빈틈입니다. 하지만 이것이 돈과 시간과 노력을 들여 뜯어고쳐야 하는 중요한 결점인지는 또 다른 문제입니다. 공학의 알파이자 오메가는 실용성이니까요.

그렇기 때문에 누군가는 공학의 언어를 이용해 이것이 그렇게 중요하지 않은 문제라 할 수도 있겠습니다. 보정과 조명을 거쳤을지언정, 대부분의 경우 얼굴 감지 기술은 어떻게든 돌아간다며 말이죠. 몇몇 흑인의 얼굴이 제대로 감지되지 않은 사례들이 있기는 하지만 그건 극히 일부이지, 전체 집단의 사례도 아니고 통계적으로 유의미하지도 않다면서요. 이런 사소한 문제를 잡기 위해서 충분히 잘 돌아가고 있는 지금의 기술을 뜯어고치는 건 낭비라고 말입니다.

그럼 저는 마찬가지로 공학의 언어를 이용해 이렇게 답할 것 같습니다. 이미지 처리 기술, 특히 얼굴 감지 기술에서 얼굴은 ‘어쩌다 놓칠 수도 있는 사물 패턴 중 하나’가 아니라고요.

인간은 얼굴을 통해 서로를 알아봅니다. 정체감, 정체성, 자기표현능력 등과 아주 긴밀히 연관되고, 자연스럽게 자신과 비슷하게 생긴 존재에 동질감을 느끼기도 합니다. 그렇기 때문에 누군가의 얼굴에 얼굴이 아니라고 판정내리는 것은 단순한 기술적 결함이 아니라 누군가의 인간성을 부정하는 선언이 됩니다. 당사자뿐 아니라 그 판정을 지켜보는, 그 사람에게 동질감을 느끼는 집단에까지 말이죠. 인종차별을 위해 만들어진 기술은 아니지만, 사회 구성원들에게 인종차별적인 경험이 퍼지고, 이는 강한 분노와 슬픔, 배제되었다는 감정을 불러일으킵니다. 앞서 언급한 버락 오바마와 미치 맥코넬의 트위터 사례가 그 증거입니다. 이것이 정말로 사소하기만 한 문제였다면, 그만한 반응과 후속 실험이 따라오지 않았을 겁니다.

많은 기술과 마찬가지로 이미지 처리 기술의 최종 목적지는 사람이기 때문에 정성적인 평가(subjective evaluation)가 중요합니다. ‘객관적으로’ 고차원인 기술, 정량적인 점수가 높게 나오는 기술이 능사가 아니라는 것이지요. 그런 관점에서, 현재 얼굴 감지 기술이 흑인에게선 잘 작동하지 않는 걸 두고 중요하지 않은 문제라 치부하긴 어렵습니다. 오히려 치명적인 정성적 결함이 있다고 해야 합니다.

앞으로 무엇을, 어떻게?

그렇다면 지금의 기술을 어떻게 바꿔야 할까요?

아쉽게도 여기서부터는 제가 답할 수 있는 영역을 벗어납니다. 저는 이미지 처리나 얼굴 감지 기술을 직접 개발하는 사람이 아니니까요. 하지만 질문 정도는 던질 수 있을 것 같습니다.

얼굴다움이란 무엇인가

사실 인간이 얼굴같이 생겼다고 인식하는 사물의 범주는 꽤 넓어, 인간의 이목구비와 꼭 닮은 것 없이도 얼굴을 찾아내기도 합니다. 저는 어릴 때 쌓아놓은 빨래에서, 나무 옹이 무늬에서 사람 얼굴을 보고 무서워했던 기억이 나네요. 팟캐스트 <빨간책방>에서 이동진 작가는 자기는 어렸을 때 바닥과 천장 무늬에서 괴물을 봤다고 했는데 아마 비슷한 경험이었을 것 같습니다. 그렇다면 얼굴다운 형상의 조건을 기존 데이터에서 주어진 이목구비와 얼굴형, 피부톤 너머로 넓혀도 괜찮지 않을까요?

어쩌면 이 질문에 대한 답은 세계 각지의 전통 시각예술이 이미 가지고 있을지도 모르겠습니다. 인간과 썩 닮지 않은 디포르메된 조각, 탈, 회화에서 우리는 얼굴을 알아보고, 각지의 행위예술에서 얼굴을 강조하기 위해 쓰인 분장법이 있었으니까요. 사진을 찍고 서구화된 미의 기준에 맞춰 화장하기 전의 기록들에서 우리는 다양한 얼굴다움과 인간다움을 발견할지도 모릅니다.

물론 이런 식으로 만들어진 얼굴 감지 기술은 1종 오류(False positive, 거짓 양성 오류) 빈도가 높을 수밖에 없습니다. 실제로는 사람이 아닌 것을 보고 사람이라고 하는 식으로요. 하지만 그것이 현재와 같이 특정 집단의 사람을 특히 배제하는 거짓 음성 오류를 감내하는 것보다 반드시 나쁘다고 볼 수 있을까요?

|

|---|

| 개의 얼굴이 보이시나요? 출처 |

그래서 다양성이 중요합니다. 다양한 얼굴다움 이 어떻게 재현되고 표현되는지, 지금의 사진 매체에서 누군가의 얼굴이 어떻게 왜곡되는지 가장 잘 말할 수 있는 것은 각 당사자일 수밖에 없으니까요. 저의 경우, 흑인이나 남미계, 동남아계 얼굴의 특징에 대해서는 잘 모르지만, 동아시아계 얼굴이 백인계 얼굴과 어떻게 다른지는 보다 잘 설명할 수 있습니다. 그렇게 각자 지역사회에 내려오는 기록과 지식을 구성원 스스로 조사하고 해석한 결과를 모아서 새로운 지식을 도출해낸다면, 보다 일반적이고 포용적인 얼굴형에 좀 더 가까워질 수 있지요. 당사자성은 능사는 아니지만 많은 경우 확실히 도움이 됩니다.

그리고 어쩌면 이것은 지금 나와 주변의 얼굴을 있는 그대로 바라보는 데서 출발할지도 모릅니다. 누구의 기준에도 맞출 필요가 없는 나의 얼굴을요. 그런 얼굴은 미디어 매체가 아니라 당장 집 안에서, 대중교통수단 안에서, 학교와 직장, 음식점에서, 말하자면 비트화되고 보정되고 선택되기 전의 날것의(raw) 삶에서 마주칠 수 있을 것입니다.

참고문헌

[1] Freney B el at., 2020, Profiling and Convention 108+ : Report on developments after the adoption of Recommendation (2010)13 on profiling. 15 p.

[2] Leslie, D., 2020, Understanding bias in facial recognition technologies: an explainer. The Alan Turing Institute.

[3] F Schroff et al., 2015, FaceNet: A Unified Embedding for Face Recognition and Clustering, IEEE Conference on Computer Vision and Pattern Recognition (CVPR), arXiv:1503.03832 [cs.CV]

[4] Honglak L et al., 2011. Unsupervised Learning of Hierarchical Representations with Convolutional Deep Belief Networks.Commun. ACM 54, 10 (October 2011), 95–103. DOI:https://doi.org/10.1145/2001269.2001295

[5] Socret L, (2020, May 22), Understanding Face Detection with the Viola-Jones Object Detection Framework [Medium post] Retreived from https://towardsdatascience.com/understanding-face-detection-with-the-viola-jones-object-detection-framework-c55cc2a9da14

[6] Sarah L, (2019, April 25), The Racial Bias Built Into Photography The New York Times Retrieved from https://www.nytimes.com/2019/04/25/lens/sarah-lewis-racial-bias-photography.html

Member discussion